Continuando con el post anterior, traigo otro code-kata, o HOWTO, para hacer ping a una web, para empezar. Digo para empezar, porque esto no es más que el comienzo de una serie de acciones muy potentes sobre servidores web. Así podemos interactuar con un sitio web automática y remotamente. Este es uno de los mecanismos básicos de comunicación entre sistemas informáticos. Es decir, esto se puede reutilizar para que una web se comunique con otra web, con otro sistema informático, leyendo información o enviándola.

Para esto vamos a usar el gran CURL, que va muy bien para trabajar con el protocolo de las webs. Aunque como reza en su web, es compatible con muchos otros protocolos:

DICT, FILE, FTP, FTPS, Gopher, HTTP, HTTPS, IMAP, IMAPS, LDAP, LDAPS, POP3, POP3S, RTMP, RTSP, SCP, SFTP, SMB, SMBS, SMTP, SMTPS, Telnet and TFTP. curl supports SSL certificates, HTTP POST, HTTP PUT, FTP uploading, HTTP form based upload, proxies, HTTP/2, cookies, user+password authentication (Basic, Plain, Digest, CRAM-MD5, NTLM, Negotiate and Kerberos), file transfer resume, proxy tunneling and more..

Esta forma de hacer un simple ping web se puede escalar todo lo que quieras. Es decir, de esta forma es como trabajan internamente los módulos de métodos de pago, envío/lectura de feeds, las APIs de los CMSs, por ejemplo. Las acciones que se ejecutan mediante la comunicación con APIs sobre HTTP/HTTPS. Y claro, cómo no, para las archiconocidas y tan queridas API REST sobre HTTP. Todas estas acciones tienen un origen (cliente) y un destino (servidor).

Así pues, vamos a complicar el ejemplo anterior..

Instalando CURL

Vamos a usar en este caso CURL, que es una herramienta del sistema operativo que podemos usar desde PHP. Si estás en GNU/Linux, puedes instalar tanto CURL como el módulo de PHP que lo usa así:

sudo apt-get install curl php7.2-curl

Si estás en Windows, Mac, o cualquier otro sistema operativo tendrás que ir a:

..y seguir las instrucciones.

Primera petición web

Así un ping sencillo queda de la siguiente forma:

<?php

$curlHandler = curl_init('jnjsite.com');

curl_exec($curlHandler);

Si ejecutamos esto desde línea de comandos veremos algo tal que así:

<!DOCTYPE HTML PUBLIC "-//IETF//DTD HTML 2.0//EN"> <html><head> <title>301 Moved Permanently</title> </head><body> <h1>Moved Permanently</h1> <p>The document has moved <a href="https://jnjsite.com/">here</a>.</p> </body></html>

El contenido de la web se está pintando por pantalla: jnjsite.com te invita a redirigirte a https://jnjsite.com que es la versión segura de la web.

Viendo información de la respuesta

Para esto podemos modificar el script anterior y sacamos mucha información de la respuesta:

<?php

$curlHandler = curl_init('jnjsite.com');

$response = curl_exec($curlHandler);

var_dump(curl_getinfo($curlHandler));

curl_close($curlHandler);

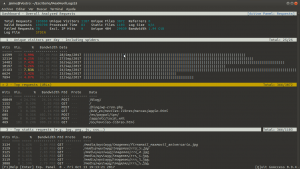

Ejecutando esto desde línea de comandos veremos por pantalla mucha más información. En concreto el siguiente array:

array(26) {

‘url’ =>

string(19) «https://jnjsite.com/»

‘content_type’ =>

string(29) «text/html; charset=iso-8859-1»

‘http_code’ =>

int(301)

‘header_size’ =>

int(254)

‘request_size’ =>

int(50)

‘filetime’ =>

int(-1)

‘ssl_verify_result’ =>

int(0)

‘redirect_count’ =>

int(0)

‘total_time’ =>

double(0.131197)

‘namelookup_time’ =>

double(0.004185)

‘connect_time’ =>

double(0.067574)

‘pretransfer_time’ =>

double(0.067664)

‘size_upload’ =>

double(0)

‘size_download’ =>

double(228)

‘speed_download’ =>

double(1740)

‘speed_upload’ =>

double(0)

‘download_content_length’ =>

double(228)

‘upload_content_length’ =>

double(-1)

‘starttransfer_time’ =>

double(0.131118)

‘redirect_time’ =>

double(0)

‘redirect_url’ =>

string(20) «https://jnjsite.com/»

‘primary_ip’ =>

string(12) «52.31.12.158»

‘crtinfo’ =>

array(0) {}

‘primary_port’ =>

int(80)

‘local_ip’ =>

string(13) «192.168.0.221»

‘local_port’ =>

int(48976)

}

En este caso nos está pidiendo hacer una redirección 301 a la web con HTTPS. En teoría deberíamos de seguir esta redirección. Así que..

Siguiendo redirecciones

Modificando el script anterior, tenemos haciendo las redirecciones lo siguiente:

<?php

$curlHandler = curl_init('jnjsite.com');

$response = curl_exec($curlHandler);

while(curl_getinfo($curlHandler)['http_code'] >= 300

and curl_getinfo($curlHandler)['http_code'] < 400){

// new URL to be redirected

curl_setopt($curlHandler, CURLOPT_URL, curl_getinfo($curlHandler)['redirect_url']);

$response = curl_exec($curlHandler);

}

var_dump(curl_getinfo($curlHandler));

curl_close($curlHandler);

Ejecutamos, y revisando por pantalla el resultado tendremos que finalmente se paran las redirecciones en https://jnjsite.com/ con un código de respuesta 200. He marcado en negrita lo nuevo con respecto al script anterior para redirigir hasta la página de destino.

Terminando

Para dejarlo limpio el script, sólo quedaría comprobar finalmente si la página ha dado un código OK de respuesta. Marco en negrita lo nuevo:

<?php

$curlHandler = curl_init('jnjsite.com');

curl_setopt($curlHandler, CURLOPT_RETURNTRANSFER, true);

curl_exec($curlHandler);

while (curl_getinfo($curlHandler)['http_code'] >= 300

and curl_getinfo($curlHandler)['http_code'] < 400) {

// new URL to be redirected

curl_setopt($curlHandler, CURLOPT_URL, curl_getinfo($curlHandler)['redirect_url']);

curl_exec($curlHandler);

}

if (curl_getinfo($curlHandler)['http_code'] >= 200

and curl_getinfo($curlHandler)['http_code'] < 300) {

echo 'OK'.PHP_EOL;

} else {

echo 'KO'.PHP_EOL;

}

curl_close($curlHandler);

A partir de aquí sólo queda hacer las acciones que consideres si tienes un OK o un KO.